Mardi et mercredi derniers avait donc lieu SEO Campus. Retour sur quelques conférences :

Philippe Yonnet sur 1 an d'évolution des moteurs

Philippe a réussi à nous résumer une année d'actualité SEO en 1h, ce qui n'est pas rien. Tous les évenements marquants ont été évoqués : montée du mobile, acquisitions Google, évolutions des interfaces, mises à jour algorithmiques... Les deux points que j'en retiens sont l'apparition de la balise link rel hreflang, passée quelque peu inaperçue, et l'insistance de Philippe sur le fait que les positions ne sont pas tout et que des pertes sensibles de positions ne se traduisent pas forcément par des pertes de trafic.

Lancement de Bing France

Bing est donc désormais officiellement lancé en France. Pour le moteur, cet évènement a été l'occasion de mettre en valeur ses partenaires (Pages Jaunes, Allociné, Gallica, GIE E-presse...) faisant de Bing "le moteur le plus français qui existe". Ce fût aussi l'occasion de promouvoir son interface, voulue plus innovante que celle des concurrents. Dixit les officiels de Microsoft, "Google est comme le DOS de la recherche, Bing veut être le Windows". La comparaison est à mon sens malheureuse quand on sait que les premières versions de Windows n'étaient qu'une surcouche graphique de DOS, càd une interface ne changeant rien au moteur derrière... La question de la pertinence n'a finalement été que très peu abordée. "C'est un débat qui appartient au passé" si l'on en croit les représentant du moteurs. A voir. Il est également regrettable que les démos utilisent toujours les même exemples. Cela réduit leur crédibilité. Concernant l'intégration des résultats Bing dans Yahoo France, celle-ci devrait se faire d'ici dans les 3 mois.

Ateliers participatifs

J'ai été amené à animer deux ateliers participatifs, l'un sur les guidelines des moteurs, l'autre sur l'écriture web. Ce format est une première pour moi et je dois avouer qu'animer un débat sur un sujet non connu à l'avance n'est pas si simple :)

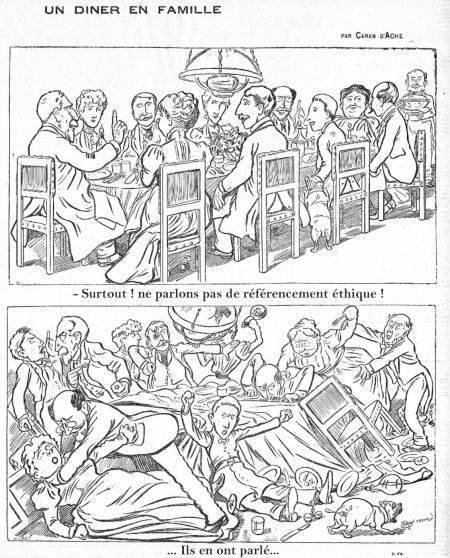

Le premier atelier sur les guidelines a donné lieu à des échanges animés entre les participants, les uns clairement black-hat, les autres clairement white-hat, et beaucoup d'autres entre deux. Il en est notamment ressorti que la distinction entre les deux mondes n'est pas si simple, ou plutôt qu'elle varie selon le critère retenu (technique ? intention ?). Le second atelier a été l'occasion d'échanger en petit comité sur les pratiques d'écriture pour le web.

Exalead sur les applications avancées des moteurs de recherche

Cette conférence s'est au final avérée très sympathique après un début un peu trop abstrait à mon goût. Rien à voir avec le SEO, mais les démonstrations technologiques d'Exalead montrent des modes de recherche et des applications très innovantes, grâce à l'extraction de sens de contenus multimédias ou non explicites. Exalead permet aussi de scraper comme un goret ;) Des exemples sur Exalabs :)

David Cohen sur la réactivité et le SEO

Une présentation pas forcément technique, mais des conseils judicieux pour suivre son référencement au plus près. Parmi les conseils que nous a donné David : abusez de la fonction de comparaison de périodes dans Analytics, annotez-y les évènements relatifs au site, constituez-vous une timeline, et segmentez dans Google Analytics les différentes parties de votre site pour une analyse plus fine.

Sébastien Monnier sur les astuces Google Analytics

La présentation de Sébastien a été une de celle que j'ai apprécié le plus, de par sa clarté. Plutôt que vous résumer les astuces décrites, je vous suggère de les consulter directement sur son site ;)

Majestic SEO

Une très bonne présentation en anglais donnant des pistes créatives pour la création de liens entrants. Une des plus élégantes est sans doute la technique de la "réclamation de liens" : recensez vos liens entrants et les pages de destination associées (avec Majestic SEO par exemple), testez les entêtes HTTP de ces pages de destination, filtrez les codes 200 et vous obtiendrez toute une liste de pages faisant des liens vers vous mais dont la page de destination ne peut être atteinte. Contactez les webmasters concernés et vous gagnerez ainsi des liens facilement.

Site clinic Google

Une déception, la teneur des conseils donnés étant à la portée de n'importe quel référenceur avec un minimum d'expérience (et encore des référenceurs auraient pu donner de meilleurs conseils). L'intérêt de faire venir 3 googlers de Dublin me semble donc discutable. Il serait plus intéressant AMHA que les équipes Google vienne avec des exemples de sites de mauvaises qualités, montrant clairement ce qui est acceptable et ce qui ne l'est pas de leur point de vue, quitte à animer à coté un site clinic.